Lavorare sui Big Data è una sfida cui le aziende, di qualunque dimensione e comparto industriale, non possono oggi sottrarsi perché nel complesso e competitivo mercato globale la discriminante per il vantaggio di una o dell’altra impresa è data dalla capacità di analizzare i dati. Provando ad immaginare quanti dati si producono oggi con Mobile, IoT – Internet of Things, Social Media, Wearable device, sensori, droni, robot e via dicendo… è facile immaginare il significato di Big Data.

Vediamo allora cosa sono i Big Data, come utilizzarli, esempi ed applicazioni nell’analisi dei dati

Indice dei contenuti

Cosa sono i Big Data: caratteristiche e le 5+1 V

Per poter dare una definizione di Big Data quanto più vicina al suo significato intrinseco (soprattutto di utilizzo), dobbiamo entrare sia nel mondo della statistica sia in quello dell’informatica. Quando si parla di Big Data, infatti, ci si riferisce alla raccolta di una tale quantità di dati (caratterizzata da un grande volume, un’enorme velocità di produzione ma anche da ampia varietà) da rendere indispensabile l’utilizzo di metodi analitici e avanzate tecnologie (Analytics, Intelligent Data Processing, Intelligenza Artificiale) per poter essere utilizzati (osservati in primis, ma anche analizzati per poterne estrarre informazioni utili, per esempio al processo decisionale).

Entrando quindi un po’ più in dettaglio nel loro significato di business, con Big Data oggi si descrive l’abilità e la capacità di fare calcoli complessi (con le opportune tecnologie) su grandi moli dati (dati strutturati e dati non strutturati, soprattutto questi ultimi) per scoprire legami, correlazioni, informazioni e conoscenza che consentano alle aziende di estrarre valore reale dei dati, fare previsioni, prendere decisioni più accurate ed efficaci.

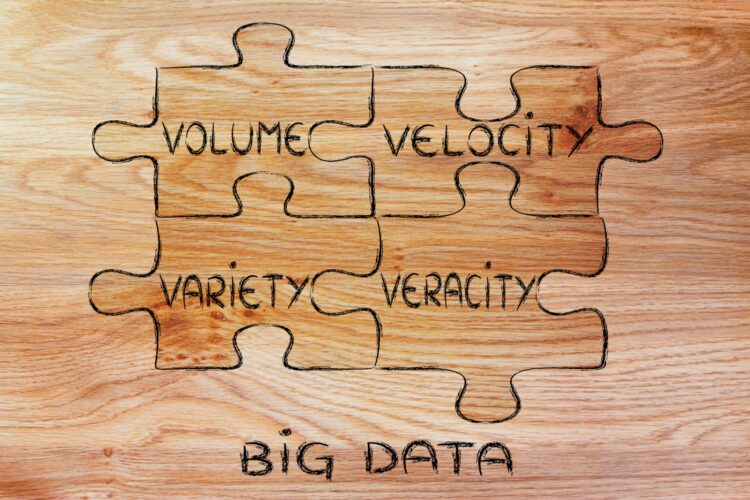

Da queste prime definizioni appare evidente che per capire cosa sono i Big Data è necessario prendere in considerazione le loro “caratteristiche”. Sono grandi moli di dati che, nell’ormai lontano 2001, l’analista di Gartner, Doug Laney, cercò di descrivere attraverso un modello semplice che facesse immediatamente capire lo scenario entro il quale stavano prendendo forma i Big Data: l’aumento esponenziale della produzione di dati, delle loro fonti e lo sviluppo e la disponibilità di avanzate tecnologie per la loro raccolta, osservazione, interpretazione e analisi, utilizzo, ecc.

Inizialmente questo modello era chiamato delle “3V” e si definivano Big Data quei dati che avessero almeno una delle seguenti tre principali caratteristiche:

Volume: in questo caso si fa riferimento alle grandi moli di dati che ormai non è più possibile raccogliere con tecnologie tradizionali. Il volume di dati (la loro produzione) è in continua espansione e gli analisti stimano addirittura che solo in questo 2020 la produzione di dati sarà 44 volte superiore rispetto al volume di dati prodotti nel 2009. Riuscire a capire quali possano essere i parametri per definire i Big Data in funzione del loro volume è arduo, tuttavia, per ora, gli analisti convengono nel ritenere Big i dati che superano la soglia dei 50 Terabyte oppure quelli che crescono più del 50% annuo (come per esempio quelli provenienti dall’IoT);

Velocità: l’ultimo parametro, la crescita annua superiore al 50%, fa capire quanto la velocità sia un’altra importante caratteristica dei Big Data. Oggi la produzione ed il “consumo” dei dati sono sempre più rapidi e spesso le aziende sono “costrette” a fare analisi in tempo reale per prendere decisioni con la maggiore e più efficace tempestività possibili;

Varietà: la varietà dei Big Data porta alla luce il passaggio dall’IT tradizionale a quello open, distribuito, esteso richiesto oggi. Quando si parla di varietà dei dati ci si riferisce alle diverse tipologie di dati oggi disponibili, provenienti da un numero crescente di fonti eterogenee che non sono più quelle dei sistemi gestionali e transazionali interni alle aziende (dati strutturati) ma anche quelli provenienti da innumerevoli altre fonti esterne che, sempre più, sono dati non strutturati (testo in linguaggio naturale, video, immagini, simboli, ecc.).

Oggi, il modello si è arricchito ed è diventato quello detto delle “5 V” perché a volume, velocità e varietà dei dati si sono aggiunte altre due caratteristiche dei Big Data:

- Veridicità: come accennato i Big Data devono poter essere analizzati per estrarne informazioni e conoscenza utili. I dati devono quindi essere affidabili, veritieri. In Informatica qualità ed integrità dei dati sono sempre stati alla base del Data Management e della Data Governance, pilastri imprescindibili anche di fronte alla sfida della Big Data Analysis;

- Variabilità: la mutevolezza dei dati e delle loro fonti è un elemento che non può essere trascurato quando si cerca di interpretare – e quindi analizzare – i Big Data, ancor di più se a farlo sono persone che non hanno competenze di Data Science.

Da tutte queste caratteristiche, in realtà, deriva anche una sesta “V”… il valore.

Il concetto di valore dei Big Data può essere facilmente compreso pensando alla nuova era della cosiddetta Data Economy: oggi i dati sono considerati il nuovo oro o addirittura il nuovo petrolio, paragoni che servono in realtà a descriverne l’inestimabile valore che producono per coloro che riescono ad estrarli, utilizzarli, monetizzarli.

Da questa prospettiva, il valore dei Big Data può esplicarsi ed esplicitarsi solo attraverso l’utilizzo di tecnologie di Big Data Analytics che consentono di trasformare i dati in informazioni e queste ultime in conoscenza utile (e di valore) per il business (per prendere decisioni migliori, migliorare le performance e/o la produttività, aumentare reddittività e competitività, ecc.).

Big Data Analytics, cosa sono e come si classificano

Ma cosa sono i Big Data Analytics? Per riuscire dunque ad utilizzare al meglio i Big Data servono le tecnologie, in particolare gli Analytics. Vediamo allora quali sono, come si possono “classificare” e in che modo possono essere utili alle aziende.

Descriptive Analytics (analisi descrittive)

Fanno parte dei cosiddetti Descriptive Analytics – che rappresentano il primo livello delle analisi avanzate dei dati – tutte le soluzioni tecnologiche che consentono di rappresentare e descrivere (anche attraverso grafi) la realtà (di eventi, processi, situazioni che si intende analizzare). Sono dunque tool che permettono di vedere una situazione presente o passata per comprenderne meglio la realtà e verificarne le performance.

Predictive Analytics (analisi predittive)

Il secondo livello nella maturità verso l’analisi avanzata dei dati è occupato di cosiddetti Predictive Analytics, anali predittive che sfruttano i dati per farne un’analisi utile ad estrapolare possibili scenari futuri (sono sistemi di analisi che utilizzano prevalentemente modelli matematici e tecniche di forecasting e modelli predittivi).

Prescriptive Analytics (analisi prescrittive)

Quando entriamo nell’alveo delle analisi prescrittive, iniziamo ad associare all’analisi dei dati una certa capacità decisionale perché unendo le forze di analisi descrittiva ed analisi predittiva, con modelli matematici e sistemi di analisi più sofisticati, ciò che ne esce sono informazioni utili e di valore come indicazioni strategiche o suggerimenti operativi che aiutano a prendere decisioni più accurate ed oggettive (basate sui dati).

Automated Analytics (analisi automatizzate)

Quest’ultimo gradino ci porta all’interno dell’automazione degli Analytics. Si tratta di soluzioni che, anche in questo caso unendo le funzionalità delle analisi descrittive e predittive, automatizzano determinate scelte/azioni che derivano dall’analisi avanzata dei dati e sulla base di specifiche regole predeterminate (che a loro volta possono derivare da un’analisi avanzata dei dati).

Big Data Analytics, un mercato che non conosce crisi

Il mercato dei Big Data Analytics in Italia ha raggiunto nel 2019 il valore di 1,7 miliardi di euro, in crescita del 23% rispetto al 2018 ed oltre il doppio se comparato al 2015, anno che ha segnato una svolta significativa negli investimenti da parte delle imprese italiane verso gli Advanced Analytics.

Secondo l’ultimo rapporto dell’Osservatorio Big Data Analytics & Business Intelligence della School of Management del Politecnico di Milano [la ricerca 2019 ha coinvolto oltre 1000 CIO, Responsabili Innovazione e Responsabili Analytics di organizzazioni utilizzatrici di piccole, medie e grandi dimensioni ed executive delle principali aziende operanti nel mercato dell’offerta – ndr].

La principale voce di spesa in Analytics è rappresentata dai software (47%), voce all’interno della quale gli strumenti specifici per la visualizzazione e l’analisi avanzata dei dati pesano per il 53% (il restante 47% è costituito da strumenti di ingestion dei dati, integrazione, preparazione e Governance).

Interessante notare che ben il 20% degli investimenti è dedicato a risorse infrastrutturali, ossia ai sistemi per abilitare gli Analytics e fornire capacità di calcolo e storage ai sistemi aziendali (tra queste voci spiccano sistemi iperconvergenti e accesso alle infrastrutture via cloud – Infrastructure as a service).

Il 33% della spesa è destinato all’integrazione con i sistemi aziendali e la consulenza per la riprogettazione dei processi.

Cosa ci dicono questi dati? Che le aziende italiane stanno investendo – seppur a vario titolo e con differenti livelli di complessità progettuale – per riuscire a trarre valore dai Big Data.

Le aziende più grandi, che hanno già compiuto importanti passi nell’ambito dell’analisi dei dati, sono chiamate oggi a governare i progetti non solo dalla prospettiva tecnologica ma anche, e soprattutto, dal punto di vista organizzativo con sfide che le portano ad un ridisegno dei processi in ottica data-driven.

Per quanto riguarda le piccole e medie imprese, nel 62% dei casi hanno fatto investimenti nel 2019, concentrati soprattutto nell’integrazione dei dati interni (80%), nella formazione di base sull’analisi dei dati per risorse già presenti in azienda (66%), nell’integrazione di dati da fonti esterne (57%) e nello sviluppo di progetti di analisi predittiva (quattro su dieci, +10%).

Nelle PMI gli obiettivi principali degli investimenti sono l’ottimizzazione della supply chain, in particolare in ambito manifatturiero, l’analisi dell’ambiente competitivo e la necessità di aumentare l’efficacia delle campagne di marketing. Tra le aziende che hanno portato avanti progetti di questo tipo, i risultati sono percepiti altamente innovativi nel 29% dei casi.

Evidente segno che anche le aziende italiane si stanno muovendo sempre più verso una trasformazione in data-driven company.

Desideri parlare con un nostro esperto? Contattaci

Ultime News Tecnologie e concetti IT

-

-

Come progettare un software: fasi dello sviluppo, gli step da seguire

21 Febbraio 2025 -

Virtual Desktop Infrastructure (VDI): cos’è e come funziona la virtualizzazione desktop

19 Febbraio 2025 -

Cos’è un software per virtualizzazione e quali sono i migliori programmi

2 Febbraio 2025 -

Cos’è un backup dati e come si fa un ripristino efficace

31 Gennaio 2025 -

Continuità operativa in azienda: cos’è la business continuity e a cosa serve

14 Gennaio 2025 -

Cos’è la digital transformation, la trasformazione digitale che rivoluziona le aziende

12 Dicembre 2024 -

Quali sono i migliori password manager e come scegliere un gestore efficace

13 Novembre 2024 -

Quando finirà il supporto di Windows 10? E cosa dobbiamo fare?

9 Novembre 2024 -

Cos’è un software: definizione ed esempi chiari per approfondire

31 Ottobre 2024

Gestione dati e analisi

-

Database Management System (DBMS): lo strumento per gestire i dati

21 Ottobre 2024 -

Cos’è il regolamento DORA (Digital Operational Resilience Act) e a cosa serve

5 Ottobre 2024 -

Tutte le novità di SQL Server e le funzionalità aggiuntive

18 Luglio 2024 -

Come fare manutenzione dei database SQL Server

8 Luglio 2024 -

Cos’è TISAX® e qual è il suo ruolo nella sicurezza dell’automotive

31 Maggio 2024 -

Come ottimizzare il tuo database con le tecniche di SQL Server Performance Tuning

20 Maggio 2024 -

Quali sono le differenze tra SQL Server e Oracle?

13 Maggio 2024 -

Cos’è e come fare monitoraggio di Microsoft SQL Server

23 Aprile 2024 -

Guida SQL Server, tutto quello che devi sapere

19 Aprile 2024 -

Data cleansing: Cos’è, Tipologie, Come pulire i dati e i Vantaggi

3 Gennaio 2024